今年春节,DeepSeek-R1无疑成了热搜的“顶流”。就连我回家后,长辈们的饭局上也频频提起它。作为国产大模型的代表,DeepSeek-R1的崛起让我们倍感振奋——我们终于不再只是技术的跟随者,而是有机会站上全球舞台,争夺“地表最强大模型”的桂冠。然而,随着流量涌入大模型赛道,舆论场也变得鱼龙混杂。一些声音为了博眼球,刻意夸大DeepSeek-R1的能力和意义,甚至误导大众。面对这样的现象,我们更需要冷静思考,理性讨论。这篇文章将从非技术的角度,聊聊几个关于DeepSeek-R1的议题。仅代表个人观点,欢迎交流与指正。

DeepSeek-R1厉害在哪里?

简单来说,最重要的三点是——“模型效果强大”、“模型开源”、“模型成本极低”。

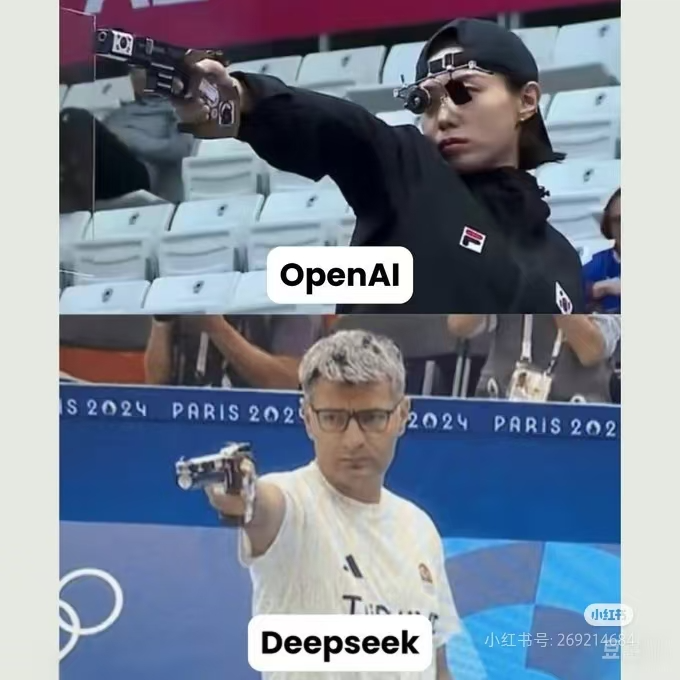

1.模型效果强大:这一点比较容易理解,意思就是DeepSeek-R1非常“聪明”。在它诞生之前,大模型领域一直由美国的OpenAI公司引领,最强的模型是2024年9月发布的o1,可以说是一骑绝尘(尽管很多厂商都自称超越了o1)。而DeepSeek-R1的出现,真正做到了与o1比肩。

2.模型开源:这一点也很好理解。DeepSeek不仅开源了模型权重(相当于《阿凡达》上映时直接公开了电影原片),甚至连训练技术也全部公开(相当于把4D电影的拍摄教程也一并分享)。这意味着所有人都可以免费使用(免费看《阿凡达》),也可以充分学习和复现(自己拍4D电影),从而推动技术社区的交流与协作。值得一提的是,OpenAI从GPT-3开始就坚持闭源路线,甚至被调为“ClosedAI”。如果你想用他们的模型?不好意思,请付费。如果你想追赶他们的效果?不好意思,自己猜技术路径吧!

3.模型成本极低:这一点可以从训练成本的角度展开聊聊。

根据公开信息,DeepSeek-R1的训练成本只有OpenAI的1/10不到。他们是怎么做到的?

💥技术路线换道超车,成本结构迎来核爆式变革💥

DeepSeek-R1的特别之处在于,它并没有主要采用OpenAI的监督微调策略,而是直接应用了强化学习。虽然OpenAI也使用了基于人类反馈的强化学习(RLHF),但其评分依赖于人类测试员,本质上仍受限于人力成本。而DeepSeek-R1的数学推理能力,则完全通过纯自动强化学习进行训练,彻底摆脱了对人力的依赖。

看不懂,没关系我们举个简单的例子: 话说「吃货城」里最有名的就是各色饭店,城西头老字号“欧式国际大酒店”久负盛名,无人能敌;但最近城东头一个叫做“迪迪家常菜”的小店却后来居上,风头正盛… 一个没什么本钱的小店是怎么做到的呢…

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

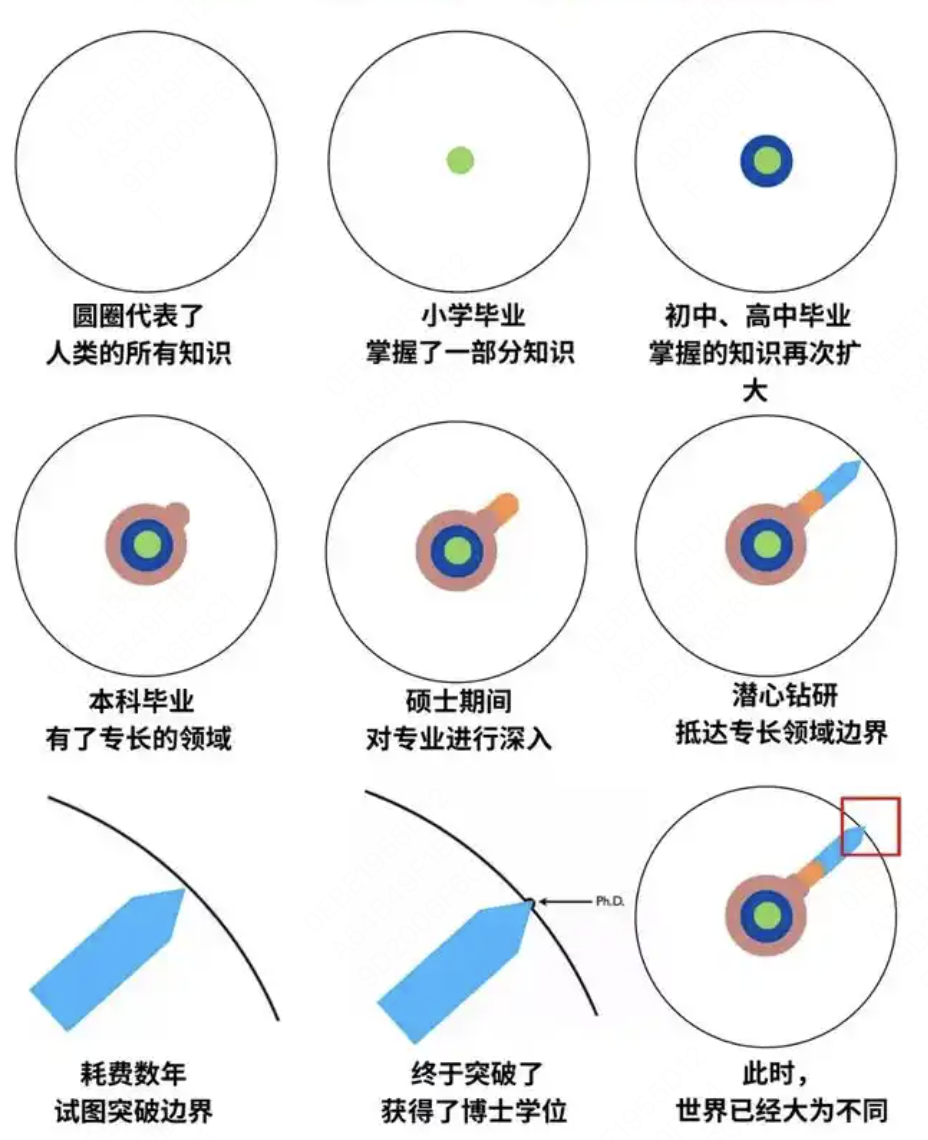

只有突破才能超越,这是DeepSeek-R1最可贵的一点。

DeepSeek-R1是万金油吗?

好了,前面我们从宏大叙事的角度吹了一大波牛。那么我们具体看看DeepSeek-R1到底好不好用,怎么用。

DeepSeek-R1不是万金油。模型这么厉害,是不是我们都切换成DeepSeek-R1就好?不同的应用场景,我们都需要根据任务特征,综合考虑模型效果、成本和性能(这很重要!)

-

简单的任务没必要

简单的任务比如不复杂的打标类任务,没有必要用DeepSeek-R1(全参600+B)。不需要用大炮打苍蝇的道理大家都理解。有很多较小参数的模型(比如开源的Qwen2.5-1.5B~14B)在这些简单任务上,具备效果佳、成本低、性能好的特点。

-

要求时延极低的任务不太灵

模型的输出token越多,输出完毕的时间就越长(输出是一个个字吐的)。复杂推理类模型,他一定有个深度思考过程,这部分的推理,也是要占时间。所以如果任务要求时延极低,比如要求几十ms内输出,就太不灵了。

3. 超长文本的任务不够用

DeepSeek-R1的最大上下文长度是64K,看着也不算短。但是别忘了深度思考过程也要占上下文,所以若为超长文本就不够用了,比如说部分AI Coding场景。

要跟DeepSeek-R1说人话。想让R1发挥更好的效果,需要抛弃提示词模版的那套思路,表达你原始需求,跟模型说人话:

我要xx,要给xx用,希望达到xx效果,但担心xx问题…

举个例子,大家感受下区别:

|

|

|

|

|

|

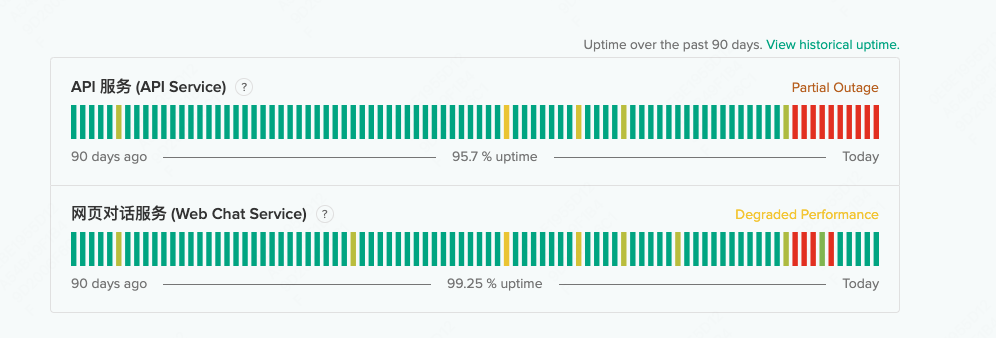

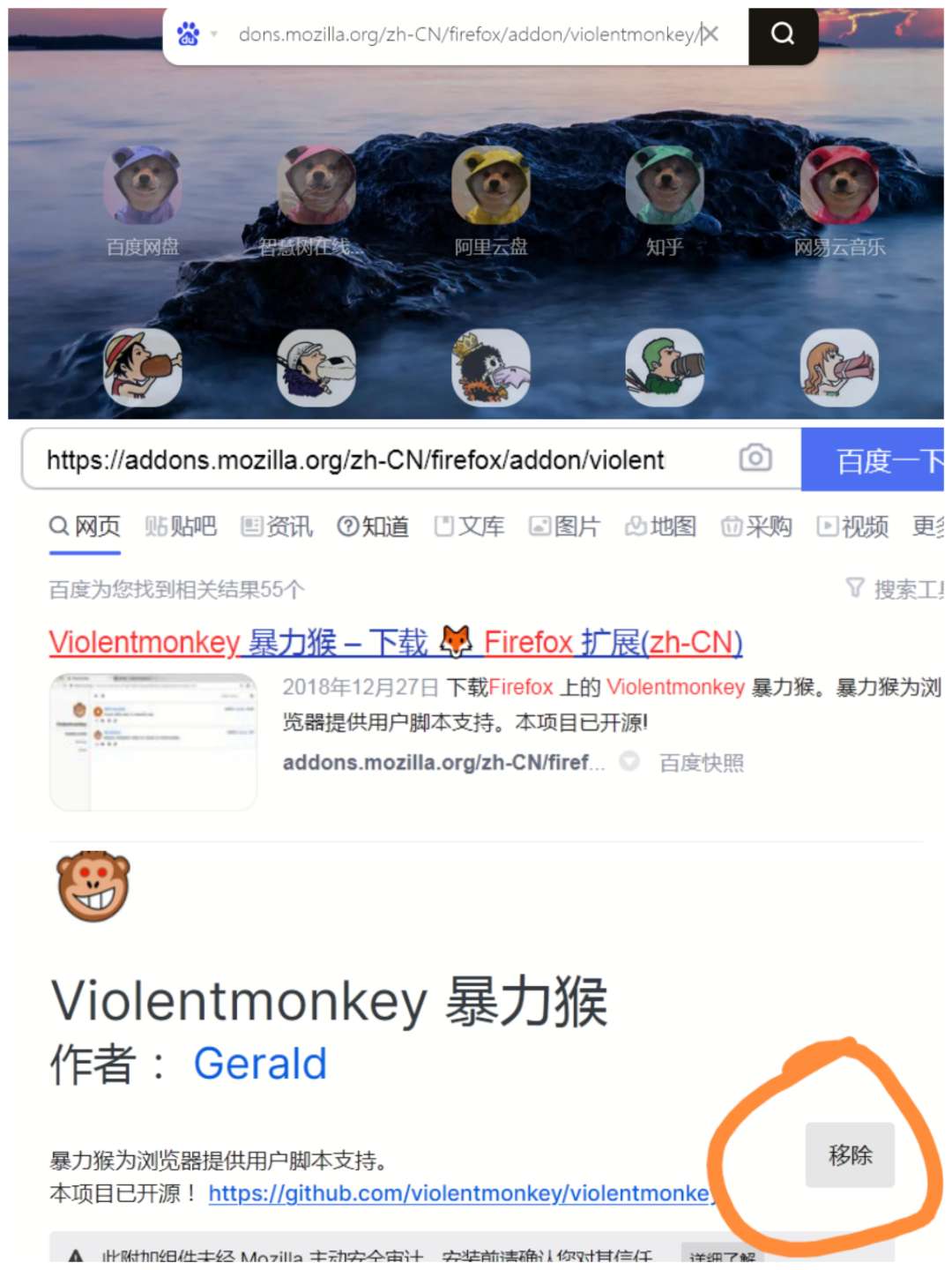

DeepSeek-R1官方服务不稳定,本地部署有手就行?

DeepSeek-R1大火并且纷纷登顶各国APP下载榜首后,DeepSeek官方服务顶不住了(小声吐槽:DeepSeek的服务在爆火之前也一直不咋稳定hhh)。

纷纷有公众号宣称,DeepSeek-R1部署有手就行,电脑上手机上都能跑!这种消息很容易给大家造成误导😓

首先,市面上所有教程中,能在电脑&手机,或者少量消费级显卡上部署的,是DeepSeek-R1的蒸馏模型,可理解为残血版。参数量在1.5B~70B之间,官方共提供了6个。然后,由于算力显存等限制,很多教程里面还叠加了量化压缩的方法,也就是在小模型的基础上再次压缩,确保能塞得进去。模型效果再次打折扣。最后,在效果打折的基础上,推理性能还会比较差。具体表现是,推理速度慢、可承载并发低。

所以,如果是部署在本地试一试,对效果要求不高,这些方法是ok的;如果是正式的线上服务,大no特no。

一将功成万骨枯,没有“先烈”,就没有“先驱”

但DeepSeek-R1的出圈又好似是必然的。在大模型技术创新的道路上,无数团队在各自的领域默默耕耘,尝试不同的技术路径,攻克一个个技术难关。这些努力或许未能最终成就一番轰轰烈烈的事业,但正是这些铺路石般的尝试,为后来者指明了方向,提供了经验与教训。技术的进步从来都不是一蹴而就的,而是无数个体与团队共同努力、试错的结果。

站在当下,我们看到了DeepSeek-R1的成功,但技术发展的脚步永远不会停歇。未来的道路上,还会有新的技术瓶颈等待突破,新的挑战等待应对。

DeepSeek R1 本地部署教程 | 高效安装,轻松上手!

2025年 DeepSeek R1 大型模型本地安装部署(文件+教程)

暂无评论内容